Deep Fusion для iPhone 11. Яблочный фейк или рабочая технология?06 октября 2019, 08:50

На сентябрьской презентации Apple показала технологию для камер iPhone, названную Deep Fusion. Тогда сообщалось, что технология все еще в работе и будет доступна с обновлением. На днях это случилось – Deep Fusion пришла с бета-версией iOS 13.2. Я ее протестировал и готов поделиться деталями, но для начала немного теории. В чем суть Deep Fusion? Apple говорит, что эта технология позволяет запечатлеть невероятные детали в самых сложных условиях съемки (но не ночных, так как для ночи предусмотрен Ночной режим). Телефон делает 8 снимков с разной экспозицией, по аналогии со Smart HDR. Далее они помещаются в буфер, где из них создаются 2 референтных снимка. Следом Deep Fusion обрабатывает каждый пиксель у этих 2 снимков с помощью нейронных сетей на Neural Engine (всего изучаются 24 млн пикселей). В процессе нейронные сети анализируют оттенки, детали, а также шумовые характеристики каждого кадра для того, чтобы выбрать лучшие участки и определить, какой уровень шумоподавления применить к каждому пикселю. Затем камера попиксельно пересобирает новое фото с проработкой деталей, выдавая 1 кадр на 12 Мп (12 млн пикселей). Deep Fusion и Smart HDR

Из этого описания можно сделать несколько выводов. Во-первых, эта технология, по сути, является новым алгоритмом обработки снимков. То есть к ней надо относиться не как к функции, а как к алгоритму, на который вы никак не можете повлиять – он сам работает и не требует вашего вмешательства, и вообще имеет схожий с уже давно существующим Smart HDR подход. Поэтому не стоит настраивать себя на радикально иной результат, как в случае с ночным или портретным режимами. Во-вторых, эта технология основана на нейронке, то есть будет самообучаться и самосовершенствоваться, как было с портретным режимом. Так что во всей красе она должна раскрыться лишь с течением времени и не стоит выносить ей сейчас финальный вердикт. Deep Fusion и Smart HDR

Корректно ли сравнивать Deep Fusion от Apple с технологий HDR+ от Google (применяется в смартфонах Pixel и является основной портов Google Камера для других Android-девайсов)? Google описывает HDR+ таким образом: делается серия кадров с разной экспозицией, которая алгоритмически перераспределяет пиксели согласно среднему цвету по всей серии кадров. Данное описание скорее соотносится со Smart HDR, но не с Deep Fusion. У Deep Fusion иная цель – поднять детализацию, сохранив среднее экспонирование путем пересборки отдельных пикселей. Если хотите, то Deep Fusion стоит воспринимать как чуть более детализированный кадр, полученный через Smart HDR. Deep Fusion и Smart HDR

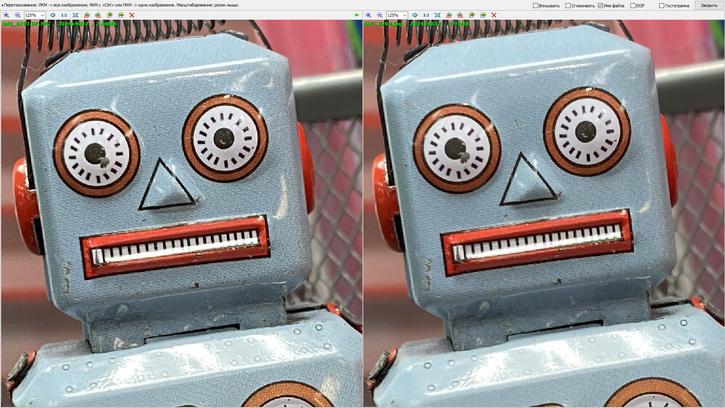

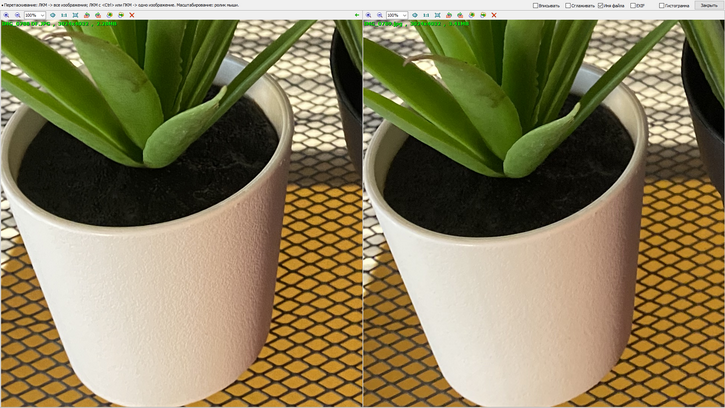

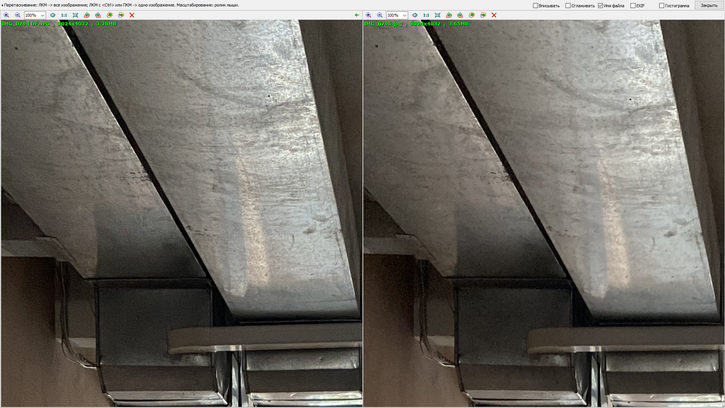

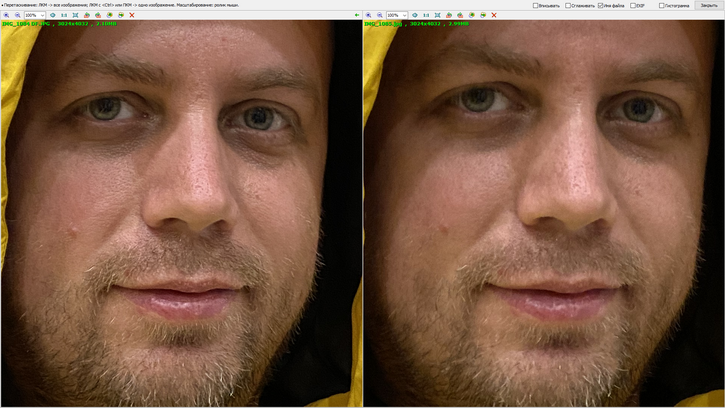

На практике так оно и выглядит: кадр с Deep Fusion очень похож на то, что выдает Smart HDR и если не приглядываться, то отличить их непросто. Но стоит посмотреть хотя бы в масштабе 100%, как детализацию замечаешь. Да, она не разительно выше, но она выше. И это именно проступившие детали (помните про пересобранные пиксели с разным уровнем шума?), а не поднятая резкость (перешарп). Deep Fusion и Smart HDR

«Но ведь Apple показывала свитер и обещала супердетализацию, а я чувствую себя обманутым!», - могут воскликнуть некоторые. И да, и нет. Это проблема завышенных ожиданий. Детализация выросла? Выросла. Сильно выросла? Тут уж как накрутили себя. Но лично я отношусь к ней как к новому алгоритму обработки снимков, на который я никак не могу повлиять – он просто есть и это нужно принять как факт, что с iOS 13.2 и выше (нейронка умеет учиться) новые iPhone 11 будут снимать с более высокой детализацией. И не заниматься перешарпом, а именно выявлять детали, которые ранее были замазаны шумодавом. После Deep Fusion предлагаю Apple переключить внимание на динамический диапазон ультраширокоугольного модуля – сейчас он является самым слабым местом тройного набора iPhone 11 Pro / 11 Pro Max. И несколько нюансов. Deep Fusion работает только на телезуме и основной камере (широкоугольной; не путать с ультраширокоугольной). И нужно снимать в Наиболее совместимом формате (JPG), так как на HEIС оно пока не работает. На телезуме DF активируется почти всегда, а вот на основном модуле включается в условиях, когда не сильно темно, но и не сильно светло – в условиях между Ночным режимом и режимом, предпочтительным для Smart HDR. Проверить, сработал ли Deep Fusion, очень просто – после снятия кадра сразу переходите в Галерею и смотрите на фото. Если оно будет сначала мутным и потом станет четким, то Deep Fusion сработал, а если будет сразу резким, то включился Smart HDR и прежние алгоритмы. Посмотрим, что Google покажет с Pixel 4. Если недалеко уйдут от Pixel 3, то есть шанс, что смартфоном года с самой оптимизированной и всесторонне сильной камерой окажется iPhone 11 Pro Max. © Евгений Макаров. Mobiltelefon Обзоры по теме: |

Обзор Honor 400

Неделя с Huawei Pura 80 Pro и Pura 80 Ultra

Обзор Vivo V50

Обзор Tecno Camon 40 Premier

Обзор Xiaomi 15S Pro с XRing O1

Обзор Dreame X50 Ultra Complete

Неделя с Huawei Mate XT Ultimate Design |